ChatGPT 两周年,以及 Dailyio 工具探索的一些回顾

过去两年,我们一直在探索使用 ChatGPT 等大模型产品的多种可能。

时间过得真快,距离 ChatGPT 发布已经过去了两年。过去两年,Dailyio 旗下的 Digital Explorer,一直在探索围绕 ChatGPT 等大模型产品的多种可能,接下来我们不妨来回顾一下若干个依托大模型构建的思考或流程。

大模型+搜索

这一年来,「大模型+搜索」的产品层出不穷,这其中,Perplexity 最具代表性,通过抓取、分析、生成若干网页内容,用户在 Perplexity 上获得的,不再仅仅是一个个网页链接,而是所谓的「答案」。

但 Perplexity 也面临一系列困境,这期 Digital Explorer 不仅探讨 Perplexity,还会探讨Perplexity 提供的「在线大模型」API 体验如何?以及还有哪些值得尝试的商业与开源「大模型+搜索引擎」服务?

更进一步,Perplexity——或者说这一类标榜 AI 的新一代搜索工具——并非发现信息的可靠工具,且不提这些工具提供的来源链接充满了幻觉;另一个原因则是,Perplexity 等新搜索工具也在成为新一代「信息看门人」,它控制着信息的流向。

在这样的背景下,我改变了使用 Perplexity 的方式,将其从搜索工具转变为可联网的大模型工具。换句话说,我不再仅仅使用 Perplexity 搜索信息,而是将它变成类似 ChatGPT 的工具,这期结合我的使用体验,分享一些思考与实践。

Claude 与 ChatGPT 渐行渐远

本周 OpenAI CFO 透露该公司的主要营收来自 ChatGPT 的收费,而多家机构预测 Anthropic 的营收主要来自 API,两家公司或者说两个产品已经走上不同的道路。

Claude 切入了一个更细分的项目管理或小团队协同的领域,从「Artifacts」到「Projects」,Claude 与 ChatGPT 已经不在一个赛道。充分利用其大模型的能力,结合企业或个人自身的数据/知识库,帮助他们优化内部协同的效率,这期内容一些我的发现和思考。

大模型+笔记

关于「大模型+笔记工具」,4 月份的时候,我分享从语音到文本的工具流程,放弃对单一笔记工具的依赖,依托不同工具的特点搭建更灵活的使用流程,包括:

- 笔记工具:Workflowy、Craft(本地版)、Obsidian、苹果「语音备忘录」;

- 大模型工具:OpenAI/Claude 的 API、通义听悟等;

两个基本点:

- 数据或内容必须可以自由迁移,特别是笔记(比如语音笔记)的原始数据;

- 不要奢望将思考外包给大模型工具,它只会分析问题,并和人类共同迭代问题的可能方案;

而借助 Obsidian 和越来越便宜的大模型 API,作为一个常年和信息打交道的内容生产者,我开始探索从信息的消费、加工、创造等环节,逐步构建起一个高效的信息管理基地,这背后既有传统的工具的「功劳」,还有各类大模型的支持,各位可通过这里详细查看。

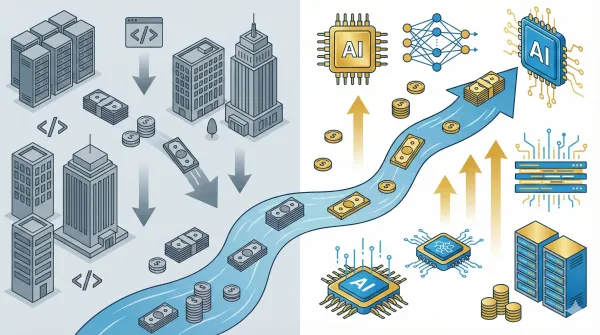

降本增效

2024 年大语言模型的选择越来越多,很多模型的能力也愈发强大,如何在内容消费与生产过程中选择合适的模型,不仅影响到自己的钱包----要知道一些模型的使用价格动辄 30、50 美元----也会影响到我的工作效率,作为内容创业者,我不想花费太多时间去调优某个开源模型,使其表现接近闭源模型,时间成本也是我需要重点考虑的因素。

在这样的背景下,我开始探索一些「降本增效」之举,比如「大小模型协同工作」。

另一个降本增效的方法是使用开源(开放权重)模型,在「开源模型越来越落后」的背景下,我以一名内容创业者的视角,阐述使用开源大模型的优势,并推荐几款优质的开源模型。另外,这期还将分享使用开源模型的实用工具与思路,为读者提供一份简明的开源大模型使用指南。

两个实验:大语言模型能胜任邮件通讯主编吗?

今年春节期间,我首次尝试让「AI 编辑」替代我的工作,撰写、编辑了多期「Dailyio Briefing」,随后我在一期 Digital Explorer 里回顾了整个流程,还没来得及阅读的朋友可以在这里了解一下。

5 月下旬刚好搬家。「AI 编辑」重新登场,主理了四期「Dailyio Briefing」(原计划出版五期)。

从 2 月中旬到 5 月下旬,这 100 多天的时间里,各类语言模型的发展,是否让我——一个长期关注大模型发展的内容创作者——感受到变化?各类模型如何影响和改变我的内容创造流程?以及,接下来的 100 多天,还会有哪些值得关注的方向?这期 Digital Explorer 的特刊,我们就来聊聊这些话题。

2024 年大模型发展水平如何?

由于工作关系,我需要经常处理大量文本内容。为了更好完成这些工作,我在众多开源、闭源模型上做了大量测试与试验,希望能够找到更适合我工作场景——包括但不限于文本摘要、文本之间的翻译、文本生成等——的大模型。

3 月的时候,我以一位大语言模型重度用户为切入点,总结过去一年多来的经验和教训:

- 如果没有万能模型,用户该怎么办?

- 为什么使用大模型是一件浪费时间的事情?

- 为 API 付费还是付费订阅在线服务?

另外,我也会对当下主流大语言模型应用做一些点评和分析,哪些是最被低估的模型、哪些是最具「弹性」的模型;另外,近期由上下文窗口与 RAG 驱动的长文本应用开始爆发,本期也会做一些盘点。

到了今年 10 月,我又分享了一份对不同模型的评测,两个提醒:

- 其一,无论是大模型体验还是他们的回答,并不存在所谓「统一标准或答案」,所以不要以我下面的内容作为标准去验证,请将这些思考当作一个参考,然后去尝试即可;

- 其二,我的测试与使用基本都是调用大模型的官方 API,通过自定义提示、模型输出温度等方式,减少诸如 ChatGPT 这类产品里的系统提示词干扰。

谈到 API,我今年逐渐减少了对于开箱即用类大模型应用的依赖,转而使用 API 构建、优化大模型的流程。

一方面,现在大模型 API 价格已经足够便宜,还能通过更灵活的调用进一步降低成本;另一方面,使用 API 也能够最大限度减少大模型对于特定提示的依赖,你完全可以依据自己的习惯,定制从系统到场景的提示词,从而获得更好的输出效果。

而要让 API 的调用更高效和方便,我需要找到一个大模型 UI——简单来说就是一个良好的前端界面与适当的功能,后端对接大模型 API——这个探索过程充满了各种有趣的发现与无知的陷阱,在体验了一众开/闭源产品后,我为什么选择 Open WebUI?,这期内容很精彩。

尾巴

大语言模型还在发展,今天(周五)ChatGPT Search 开放、Google 推出带有搜索功能的 Gemini API,围绕信息入口的竞争持续升温。我们有理由相信,接下来整个产业的发展,将给我们这些用户带来巨大的技术红利。