从素材到成文,揭秘 Dailyio 的大模型写作全流程|Digital Explorer#055

对于严肃写作来说,大模型的「写作流程」依然需要人类的深度介入。

Editor’s Note

今天是 2025 年 3 月 4 日,您正在阅读的是第 55 期 Digital Explorer。

使用大模型写作已经不是什么新鲜的事情。特别是春节之后的这段时间,由 DeepSeek R1 模型生成的内容充斥在中文互联网的各个角落。

作为从 ChatGPT 一上线就开始尝试引入大模型写作的内容工作者,过去两年多来,我一直在不断探索、尝试各类基于大模型的写作流程,每一次尝试的过程都充满了惊吓、惊喜与遗憾,在「哇」与「唉」之间不断切换。

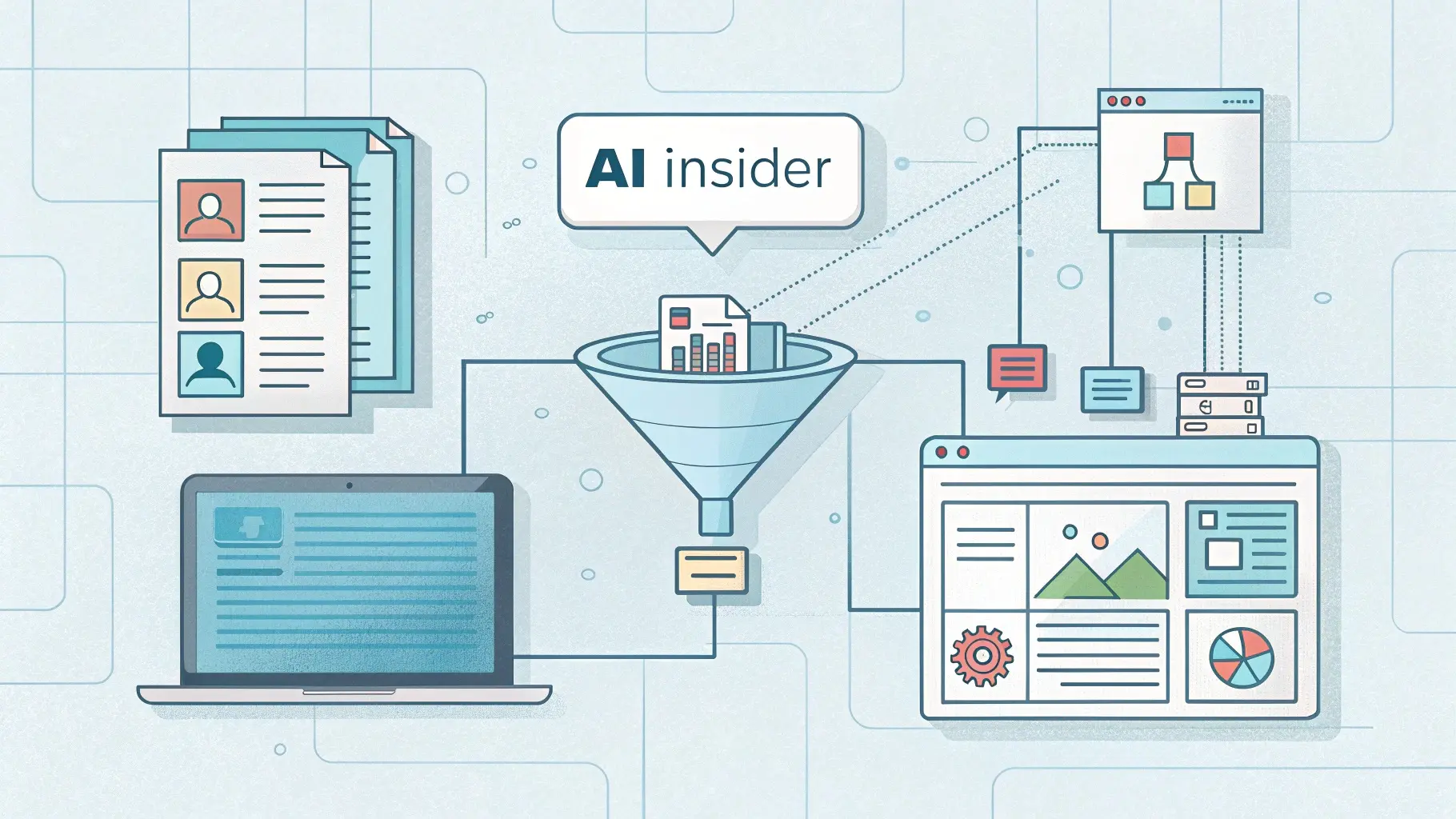

由于新模型不断涌现——请允许我使用这个词——以及模型基础能力不断完善,使得我使用大模型写作的流程也在不断迭代之中,本期 Digital Explorer,我会以聚焦产业发展的「AI Insider」邮件通讯生产流程为例,谈谈大模型如何「赋能」我的工作流程。

「AI Insider」的核心是从每周甚至每天无数杂乱的 AI 产业资讯中找到一系列线索,然后由这些线索勾勒出一个个观察产业发展的角度,并通过文本的形式展示出来,这个过程需要解决几个问题:

- 如何发现素材:不要指望大模型可以帮你发现素材,这个工作只能由人类完成;

- 如何高效处理素材:当你需要快速阅读一篇文本素材的时候,大模型除了简单的「总结」还能做什么?

- 如何让大模型写作:「素材+大纲」的确可以让大模型「写」出一些东西,但是否可以让「(你的)风格」也融入写作之中?

鉴于「如何发现素材」只属于人类,我们接下来就从「高效处理素材」的「获取」开始。

获取内容素材

每一期「AI Insider」的生产过程,我都会整理一大堆内容素材,包括但不限于新闻、观点评论(Twitier)、图片等,这其中新闻的比重往往最多,那第一步就是要获取新闻全文。

我一直不建议使用诸如「AI 搜索」或让大模型访问 URL 直接获取新闻全文的方法,原因无他,不稳定。一方面是潜在的「幻觉」问题,比如很多模型服务经常返回不存在URL 内容。另一方面则是不同媒体机构、网站都有一些「反爬虫」的策略,导致直接使用 URL 的方式经常出错。

我的策略是使用基于 Chromium 引擎的浏览器,比如 Brave,借助两个浏览器扩展:

- 「bypass paywalls clean」可以快速越过某些媒体机构的付费墙,直接查看到原文,另外也可以借助诸如「archive.today」这样的网页存档站点查看;

- 「MarkDownload」可一键将网页转换为 Markdown 或 TXT 格式的文件,支持复制或下载到本地,我推荐使用 md 格式,可以得到网页文章里的各类超链接;

通过上述方式,我们可以获取到几乎所有主要新闻站点的文本素材。

处理素材的提示词

事实上,处理内容素材的提示词有很多,我一般以最终结果倒推,以此确定如何处理这些素材。比如,我希望在「AI Insider」的素材里,不仅要看到发生了什么、有哪些关键的事实、数据,还想进一步了解其潜在影响,所以,我构建了一个不止于「总结文本」的提示词,灵感来自于「苏格拉底提问」:

请阅读下面的新闻文章,并依次回答以下问题,以运用苏格拉底提问法归纳文章的基本内容和关键细节。

1. 核心摘要:

- 文章最主要的论点或结论是什么?

- 文章披露了哪些主要事件或事实?

2. 关键细节:

- 文章列举了哪些具体的数据、事实或例子来支持其论点?

- 这些关键细节如何增强或验证文章的核心内容?

3. 证据与推理:

- 作者采用了哪些证据来论证文章观点?这些证据是否充分和具有说服力?

- 是否存在某些数据或例子隐含着其他可能的解释?

4. 隐含假设与前提:

- 在文章中是否可以发现未明说的假设或前提?这些假设又如何影响整体论述?

- 如果剥离这些假设,文章的论点是否依然成立?

5. 综合反思与启示:

- 经由上述问题思考,文章中最具启示性、值得继续探讨的线索是什么?

- 从整体上看,归纳出文章基本内容与关键细节后,对你的科技内容创作有何启发?

"""文本内容"""

更进一步,我们还可以使用下面这个基于「Enrich」的提示词,用来处理某些观点类的内容素材:

请不要简单总结下面的文章内容,而是对其进行深度丰富(Enrich),具体要求:

1. 首先提供文章的核心主张和关键观点(不超过3点)

2. 挖掘文章背后的思想模型和概念框架

3. 分析作者的推理路径和论证结构

4. 识别文章中隐含但未明确表达的关键假设

5. 将文章内容与相关领域的知识体系进行连接

6. 提出2-3个基于文章但超越文章本身的深层次思考问题

请以结构化的方式呈现上述内容,使我能够不仅理解文章表面信息,而且能够掌握其深层含义和应用价值。

文章内容:"""文本素材"""

基于上述两个提示,基本可以覆盖「AI Insider」内容素材的处理需求,我会将处理好的素材放在 Obsidian 里,后续也可以充分利用「文件夹」、「标签」或其他元数据进行管理。

构建样本风格

一般来说,当素材处理完毕之后,叠加一份自己思考的大纲,将「素材+大纲」交给大模型,就能快速写作了,但我还想让大模型模仿我的风格,结合「素材与大纲」进行写作。

下面是一个「分阶段模仿风格进行写作」的提示词:

第一阶段:风格学习

我将提供一篇或多篇我的写作样本。请:

1. 进行深度风格分析,识别以下特征:

- 语言风格(用词偏好、句式特点)

- 行文结构(段落组织、层次展开)

- 表达手法(修辞方式、举例特点)

- 互动方式(与读者对话的方法)

- 情感基调(文章的整体感情色彩)

2. 总结我的写作特征图谱:

- 列出3-5个最显著的风格特点

- 提取常用的表达模式

- 概括标志性的写作习惯

3. 请确认风格分析结果,并根据我的反馈进行调整

第二阶段:内容创作

在掌握我的写作风格后,我会提供新的创作素材。请:

1. 基于新素材,运用已习得的风格特征:

- 使用相似的语言表达方式

- 采用一致的结构组织方法

- 保持相同的互动模式

- 延续原有的情感基调

2. 创作要求:

- 保持风格一致性

- 确保内容原创性

- 适应新主题特点

- 突出核心信息

3. 创作后请说明:

- 如何在新内容中应用了我的风格特征

- 在保持风格同一性的同时如何适应新主题

- 是否需要风格上的微调

现在,请先让我提供写作样本,进行第一阶段的风格学习。完成风格分析后,我们再进入第二阶段的内容创作。

分析这个提示词结构,首先是要大模型学习我的写作样本,然后再模仿样本里的风格,将「素材+大纲」变成一篇可读的内容。

除了这个提示词之外,各位也可以研究一下下面的提示词,它需要大模型与用户不断互动,一般 5 篇左右的样本就够了:

我将为你提供我自己的书面材料,你的任务是理解并模仿其风格。

你将通过说"开始"来开始这个练习。之后,我会呈现一个示例文本,你要回应"继续"。这个过程将以类似的方式继续进行,包括另一段写作和更多的例子。我会给你无限的例子。你的回应只能是"继续"。只有当我说"结束"时,你才被允许改变你的回应。

在此之后,你将根据我给出的写作样本探索并理解我写作的语气、风格和特点。最后,我会提示你就指定的主题创作一篇新的文章,模仿我独特的写作风格。

这里的「写作样本」就是我过去写过的一些文章,需要注意几点:

- 需要自己手工挑选写作样本,找到最有代表性的文本示例,可以常备 5 个样本,关注表达、遣词造句甚至标点符号的使用;

- 单个写作样本的字数要适中,单个样本大概 300 到 400 汉字就足够了;

- 需要不断迭代写作样本,所谓风格是一件非常玄乎的事情,每个阶段可能都有所不同,需要时刻关注自己喜欢的风格是否发生变化;

基于这样的目标,我一直在积累、优化自己的「写作样本库」,使其最能反映我在「AI Insider」里的内容风格。

写作过程一览

当「样本风格」没有问题之后,就可以让大模型按照「特定风格+素材+大纲」进行内容创作了,还可以补充一些特定要求,比如字数、格式(是否有小标题)等,下面是一个示例:

第一步,将「分阶段模仿风格进行写作」提示词(见上面)交给大模型。

第二步,收到回复后,将「写作样本」交给大模型处理:

这是样本:"""xxxx"""

第三步,根据大模型的回复,确定风格分析是否有问题。

第四步,交给大模型新素材,让其模仿特定风格,开始写作:

请模仿我的写作风格,根据素材,撰写 400 字的分析,不要有小标题:"""内容素材"""

第五步,根据回复,确认是否满足自己的需求,然后进行进一步的调整与优化,这个阶段,你也需要决定,是否使用大模型写出来的草稿。

关于模型的选择

当时间来到 2025 年 3 月,选择什么样的大模型、使用 API 还是对话应用完成上述工作也变得非常重要,毕竟,太多的选择也意味着要花费相当多的成本,无论时间还是金钱。

以「AI Insider」的生产过程为例,我倾向于使用大模型 API 的方式。一方面可以保持足够的灵活性——我可以在诸如 Open WebUI 或 LobeChat 里灵活切换;另一方面,「用多少付多少」的模式也能有效控制模型使用成本。

其次,目前主流的大模型都能合格地完成素材处理的工作,但还是有几个小提醒:

- Gemini 系列模型的大上下文窗口能力非常实用,如果有长文本素材,建议使用这个模型;

- 国内模型,比如 Qwen、Doubao 系列的文本处理能力都不错,但一定要注意这些模型里的「审查」机制,当遇到某些所谓「敏感」文本的时候,很可能会影响素材处理的结果;

第三,至于风格模仿与写作的场景,我依然首推 Claude 3.5 Sonnet(6 月版本)或者最近发布的 3.7 Soneet,两款模型都能良好处理写作样本,并且可以模仿特定风格,撰写新的文本。

特别强调一点:千万不要迷信 DeepSeek R1 的写作能力,在「AI Insider」这类涉及到大量事实、数据的商业写作场景里,R1 模型的「幻觉」非常致命,它会将大量编造的事实与数据,隐藏在华丽的辞藻与严密的逻辑之下,用「华而不实」来形容 R1 的商业写作,一点也不为过。

另外,我在上个周末深度体验了 GPT-4.5,震撼于这款模型在商业写作场景中的巨大提升,它能够较好遵循用户的指令,快速完成文本风格的学习,然后再以这种风格生成新的内容,文本表达、逻辑推演都极相当精准,后续我会进一步测试它的能力。

写在最后

如果站在当下的时间节点进行回顾,大模型在文本创作方面的进步显而易见,更好的指令遵循能力、持续迭代的人类道德或品味的对齐能力以及推理能力等等,都在不断提升大模型的「写作」能力。

不过也需要看到,对于严肃写作来说,大模型的「写作流程」依然需要人类的深度介入,它的整个机制还是遵循「Garbage in,Garbage out」的基本定律,你能在「input」阶段给出怎样质量的「数据」,对于「output」的结果有很大影响。

也因此,我强烈建议各位读者将更多的时间和精力放在准备数据或素材的阶段,将自己的品味、思考融入素材收集、整理的流程中,然后引导模型给出回复,无论是得到一个回答还是获得一篇文章——它们都是人与机器协作的成果。