一周三次改名、安全漏洞百出,OpenClaw 为何仍在病毒式传播

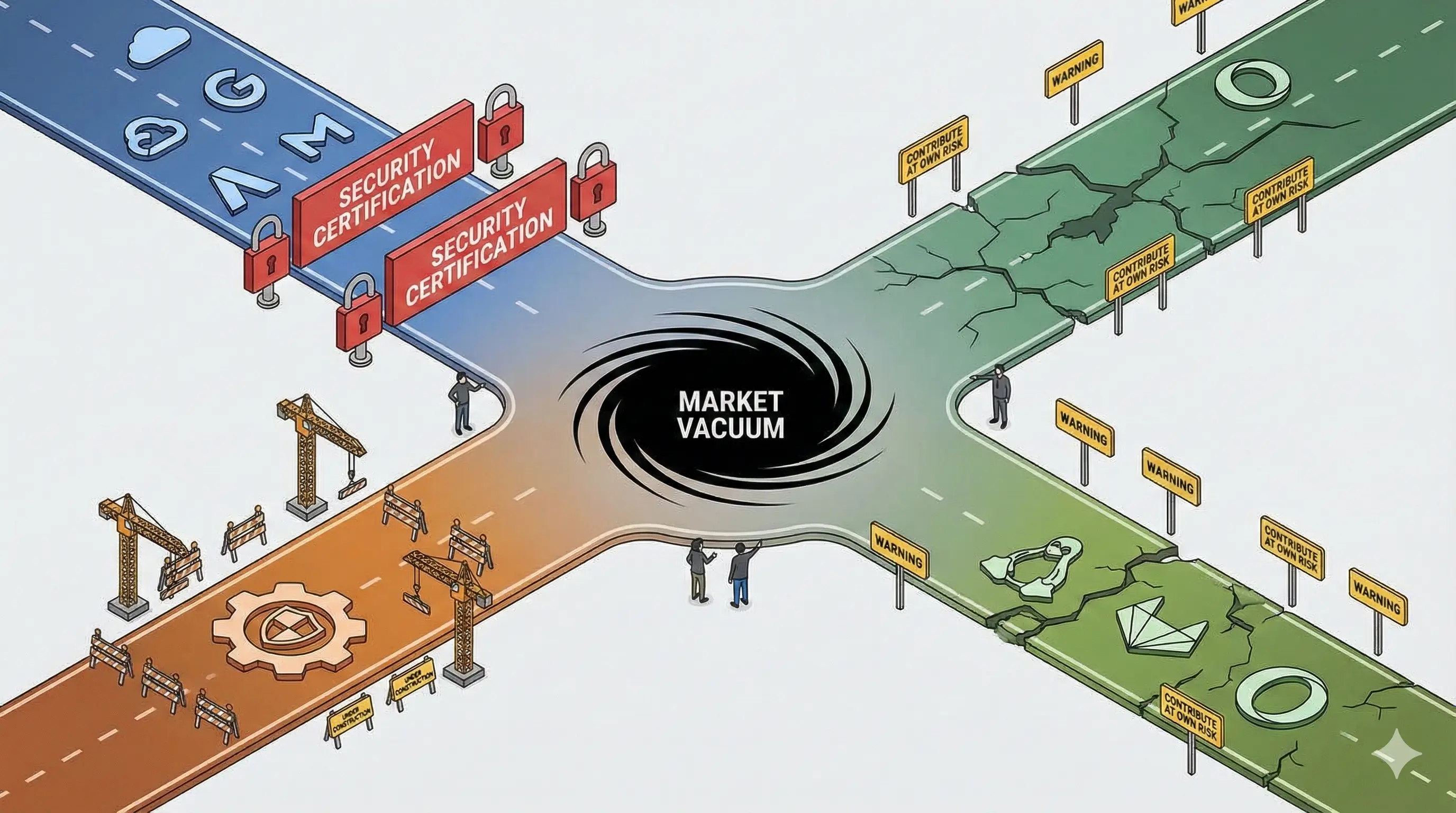

主流 AI 公司的产品保守策略,正把用户推向危险的开源方案。

Editor's Note

🗓️ 2026.02.03 | Issue#338

一周内三次改名,从 Clawdbot 到 Moltbot 再到 OpenClaw。数百个控制面板暴露在公网上,泄露 API 密钥。假加密货币骗局、钓鱼网站、被劫持的 GitHub 账号。这样的混乱足以让任何正常产品死亡。

但 OpenClaw 没有。GitHub stars 冲到 11 万,22% 的企业员工绕过 IT 部门自行安装,用户专门购买 Mac Mini 来运行它,烧掉上亿 tokens 的 API 费用。

这个反常现象背后,是 AI 产业正在经历的「能力过剩」危机。大模型已经强大到可以完成真正的任务自动化,主流产品却仍把它们困在聊天界面的安全围栏里。供需错配到临界点时,用户宁可接受风险,也要获得实际价值。

本期 AI Insider 将分析三个核心问题:为什么主流 AI 公司做不出(或不愿做)这样的产品?用户的「非理性」行为说明了什么?这个危险的真空地带最终会如何被填补?

一周内三次改名,从 Clawdbot 到 Moltbot 再到 OpenClaw。这个混乱的更名过程本该让用户失去耐心,结果却恰恰相反。GitHub stars 冲到 114,000,22% 的企业员工绕过 IT 部门自行安装。与此同时,安全研究人员发现数百个控制面板暴露在公网上,泄露 API 密钥和聊天记录。

表面看,这是一起典型的开源项目安全事故。但当用户明知风险仍蜂拥而至,甚至专门购买 Mac Mini 来运行它、烧掉 1.8 亿 tokens 的 API 费用,我们需要追问:为什么?

OpenClaw 的病毒式传播暴露的真正问题,是 AI 产业正在经历一场「能力过剩」危机。大模型已经强大到可以完成真正的任务自动化,主流产品却仍把它们困在聊天界面的安全围栏里。这个供需错配创造了一个危险的真空地带,用户为了获得实际价值,宁可接受安全风险。

主流 AI 公司为什么不做这样的产品?

OpenClaw 的核心功能并非技术突破,它只是把已有的能力组合起来:运行在本地、连接消息 app、可以访问文件系统和执行命令、能记住长期对话。但正是这些看似简单的组合,让它做到了 Claude、ChatGPT 都做不到的事:自动化邮件处理、跨平台任务编排、甚至通过邮件谈判买车。

问题的关键在于,主流 AI 公司完全有技术能力做出类似产品,但他们选择不做。安全和合规考虑是主要原因。一旦 AI 能访问文件、执行命令、发送邮件,prompt injection 攻击的后果就从「生成错误内容」变成「泄露敏感数据」或「执行恶意操作」。OWASP 将 prompt injection 列为大语言模型应用的首要风险,这让主流公司在产品设计上非常保守。

OpenAI Applications CEO Fidji Simo 在去年的文章中直接指出,AI 公司应该做更多来「解决能力过剩(capability overhang)」问题,构建真正的「个人超级助手」。这个罕见的公开表态,恰恰证明了问题的严重性。当模型能力远超产品能力时,市场会自己找到出口。

OpenClaw 就是这个出口。它的成功说明了一个残酷的现实:用户需要的 AI 助手,主流公司暂时无法提供,或者说,不愿承担风险去提供。这个真空地带,正在被开源项目填补。

理性失效的时刻

更值得警惕的是用户行为。Token Security 报告称,在分析的一周内,22% 的客户有员工在使用 OpenClaw。Noma Security 发现,超过半数企业客户的员工未经批准就授予了该工具特权访问。这是典型的 Shadow IT,但规模和速度都前所未见。

这里存在一个违背直觉的现象:用户对安全风险的认知并不缺失。Forbes 详细报道了暴露的控制面板、Malwarebytes 记录了钓鱼域名和假加密货币,长期观察 AI 产业发展的技术专家 Simon Willison 直接将其列为「最可能导致 Challenger 灾难的安全风险」。

然而用户仍在涌入。MacStories 主编 Federico Viticci 描述了自己如何专门购买 M4 Mac mini、烧掉 1.8 亿 tokens、让 AI 访问 Gmail 和 Notion,最后总结道:「这是我近年来感受到最高程度数字智能的时刻。」这种明知山有虎、偏向虎山行的选择,背后是什么?

答案是:供需错配到了临界点。当用户看到 AI 真正能做什么(自动化重复任务、跨平台协调、长期记忆和主动提醒),再回到主流产品的聊天界面时,落差感是巨大的。就像 Viticci 提出的那个尖锐问题:「当 AI 可以根据我的需求即时创建功能,我为什么还要去 App Store 寻找别人做的通用方案?」

更吊诡的是所谓「本地运行」带来的安全感。OpenClaw 的宣传重点之一是「数据留在你的机器上」,这让很多用户相信它比云服务更安全。但实际上,风险只是被转移了。从信任云服务商,变成用户自己负责配置、更新、权限管理。Forbes 引用的研究显示,大量暴露的控制面板都是配置错误导致的,没有被黑客攻击。复杂的安装过程(涉及 OAuth、API 密钥、系统路径)让普通用户更容易犯错。

这种现象背后的逻辑是:当某个需求足够强烈,人们会系统性地低估风险、高估自己的能力。企业 IT 部门被绕过,专业判断被搁置,安全最佳实践被忽略。供需错配到临界点时,理性会暂时失效。

谁来填补这个真空?

真空不会长期存在。OpenClaw 证明了市场需求真实存在,也暴露了当前产品形态的脆弱性。Moltbook 的设计尤其危险:让 AI agents 每 4 小时自动从互联网获取并执行指令,这个机制本身就是安全噩梦。Simon Willison 的警告很直接:「我们最好希望 moltbook 的所有者永远不会作恶或被攻击。」

产业面临三种可能路径。第一种是主流 AI 公司推出更开放的产品。这需要在安全和功能之间找到新的平衡点,技术上并非不可能,但需要承担责任。目前看,只有 OpenAI 的 Fidji Simo 公开表态支持这个方向,具体产品还未出现。

第二种是中间层方案。DeepMind 在去年提出的 CaMeL 提案试图构建「受控自动化」框架,但 10 个月过去了,仍未见到令人信服的实现。这条路径在理论上最优雅(既释放模型能力,又保持安全边界),但工程实现难度极高。

第三种是持续的「规范偏离」(normalization of deviance):越来越多人接受风险,直到真正的灾难发生。这是最危险的路径,也是目前正在发生的。每增加一个用户,集体心理的安全阈值就降低一点。

对中国 AI 公司来说,这个真空既是机会也是挑战。中国市场对「能力释放」的监管环境可能不同于美国,部分公司在产品激进程度上可能有更大空间。但安全问题是全球性的,prompt injection、数据泄露不会因为市场不同而消失。真正的机会可能在于找到「中间层方案」:在保持合规的前提下,提供比主流产品更强的自动化能力。

能力过剩的代价

OpenClaw 在 5 天内三次改名,每次都带来更多混乱,也带来更多用户。这个反常现象背后,是供需错配到临界点后的市场自我修正。Simon Willison 的观察很清楚:「需求是真实的。人们已经看到不受限制的个人数字助手能做什么。」

问题已经不再是「是否应该做」,变成了「谁来做、怎么做」。OpenClaw 证明了用户愿意为真正的自动化承担风险,这个信号无法被忽视。主流 AI 公司面临选择:继续保守策略,看着市场被开源项目占领;还是承担风险,构建更开放但可控的产品?

答案将决定未来几年 AI 产业的格局。能力过剩的危机不会自行消失,它只会以某种方式被解决。可能是负责任的产品创新,也可能是一场真正的「灾难」。

OpenClaw 的三次改名只是开始,真正的考验还在后面。