Google 的 AI 逆袭:为什么全栈能力比模型性能更重要

在 AI 竞赛中,控制从芯片到产品的完整技术栈,比拥有最好的模型更重要。

Editor's Note

🗓️ 2026.01.15 | Issue#333

2015 年,当 Google 决定自研 AI 芯片时,这看起来像是一个分散精力的错误决定。十年后,这成为它击败 OpenAI 的关键武器。这个案例提出了一个尖锐的问题:如果 AI 竞争需要十年芯片研发、数十亿美元人才投资和数亿用户生态,创业公司还有机会吗?

本期 AI Insider 通过分析 Google 从芯片、研究到产品的完整布局,试图回答 AI 时代的竞争到底比拼什么。对于正在押注 AI 的中国科技公司来说,这个问题同样关键:在芯片供应链受限的情况下,「全栈」路径还走得通吗?

2025 年 11 月,Google 发布 Gemini 3 后,OpenAI CEO Sam Altman 宣布内部进入「Code Red」状态。这个场景充满反差:三年前的 2022 年 11 月,正是 ChatGPT 的推出让 Google 陷入慌乱。《华尔街日报》和《金融时报》近期的深度报道呈现了这场反转背后的逻辑:Google 早在 2011 年成立 Google Brain,2014 年收购 DeepMind,2016 年就宣布「AI-first」战略,却在 ChatGPT 推出后被认为落后。但到 2025 年底,Google 已经在模型性能、用户规模和商业化上追平甚至超越 OpenAI。

这引出了一个核心问题:为什么研究历史更长、资源更丰富的 Google 会在 2023 年初落后?又如何在三年内完成反超?答案不在于谁的 chatbot 更聪明,而在于谁掌控了从芯片到模型再到产品的完整技术栈。

十年芯片投资在关键时刻显现价值

2015 年,Google 做出了一个在当时看来颇为分散精力的决定:自研 AI 芯片。这个决策的逻辑很简单,Google 相信 AI 应用需要远超当时水平的计算能力,而依赖外部芯片供应商会成为瓶颈。于是 Google 开始开发张量处理单元(TPU),这种芯片的设计目标是比 CPU 或 GPU 更节能。

十年后,这个决策的价值在 Gemini 3 发布时充分显现。Google 最新的 Ironwood 芯片显著降低了运行 AI 模型的成本。更重要的是,当 Nano Banana 图像生成工具在 2025 年 8 月意外爆红、用户生成数十亿张图像时,Google 不得不紧急借用服务器时间来满足需求。如果没有自研芯片的能力,这种算力瓶颈会更加致命。

2025 年 11 月,Google 与 Meta 就出售数十亿美元芯片进行谈判的消息传出,Nvidia 股价当天暴跌 7%。这个细节展现了更深层的竞争格局:Google 不只是在做 AI 模型,而是在构建 AI 基础设施。DeepMind CTO 兼 Google 首席 AI 架构师 Koray Kavukcuoglu 在采访中强调,Google 的优势在于「full stack approach」,即从硬件、数据中心到芯片的完整控制。

相比之下,OpenAI 依赖外部芯片供应商,还需要不断融资来支撑研发。这种差异决定了谁能做长期投资、谁必须追求短期变现。Google 可以用自有利润资助十年芯片研发,而 OpenAI 的每一步都受制于投资人的耐心。

研究整合的阵痛换来模型能力的跃升

2023 年初,Google 启动了一个痛苦的整合过程:将文化迥异的 Google Brain 和 DeepMind 合并。前者专注研究,后者专注产品,两个团队的碰撞一度造成内部紧张。但这个整合最终在 Gemini 3 上产生了结果。

Google 在训练 Gemini 时选择了一条更难的路:不只是文本,而是同时训练文本、代码、音频、图像和视频。这种多模态训练比 OpenAI 最初主要基于文本训练 ChatGPT 要耗时得多。前 Google Brain 员工 Julia Winn 的解释很直白:Google 对安全性的重视程度远超其他公司,这让早期进展缓慢。

但长期投入带来了回报。Gemini 3 可以根据用户提问决定是展示图片表格、还是写一段代码生成交互式模拟。这种「高层次的代理行为」让 Google 产品经理 Josh Woodward 感慨:「我们开始主动寻找这个功能,不只是为了测试,而是真的想用它。」

更值得注意的是 Google 对人才的投资。2024 年,Google 花 27 亿美元收购 Character.AI,本质上是为了让两位研究员 Daniel De Freitas 和 Noam Shazeer 回归。已退休的联合创始人 Sergey Brin 在一次派对上被 OpenAI 研究员「激将」后重返工作,此后一直深度参与技术细节。这些看似昂贵的投入,都在 Gemini 3 的进展中得到验证。

产品生态形成用户反馈的正向循环

Google 在 2025 年 5 月推出了 AI Mode,这是多年来对搜索引擎最大规模的改造。搜索副总裁 Liz Reid 面临的挑战是:如何让 AI 驱动的搜索既保持速度,又能提供 chatbot 式的对话体验?她的团队经过无数次迭代,终于找到了平衡点。

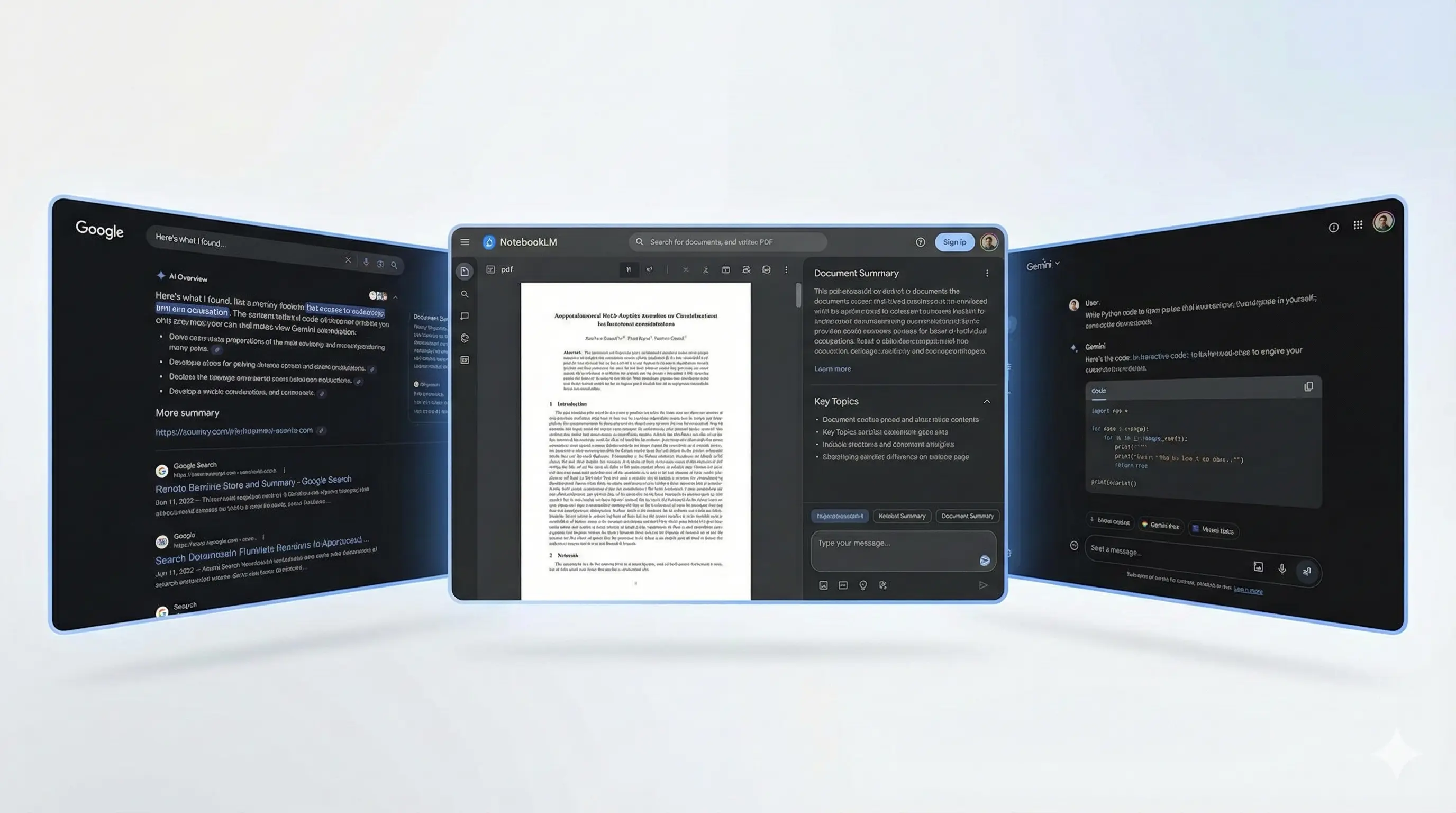

这种产品整合的价值在数据上体现得很清楚:2025 年 10 月,Gemini 的月活用户从 7 月的 4.5 亿增长到 6.5 亿。NotebookLM(Google 的 AI 笔记助手)之所以受欢迎,正是因为它可以上传各种文档并进行提问,这依赖于 Gemini 强大的多模态理解能力。

Kavukcuoglu 在采访中反复强调一个观点:「我们不只是发布模型,我们与产品一起发布精心设计的用户界面和交互方式。」这句话展现了 Google 与 OpenAI 的根本差异。OpenAI 需要通过 API 或 ChatGPT 触达用户,而 Google 可以将 Gemini 直接整合到搜索、地图、生产力工具中,形成一个从用户反馈到模型改进的完整闭环。

这个闭环的价值在反垄断案中得到了意外验证。2025 年 8 月,联邦法官裁定 Google 在搜索和搜索广告领域拥有非法垄断地位。但 Google 的律师辩称,AI chatbot 的兴起已经打破了这种垄断。法官接受了这个论证,允许 Google 与苹果每年 200 亿美元的默认搜索引擎协议继续执行。讽刺的是,Google 当初的「谨慎」最终成为了法律上的护身符。

全栈能力重新定义 AI 竞赛规则

Google 的案例呈现了一个产业规律:AI 时代的竞争不是百米冲刺,而是马拉松。单点突破可以赢得第一波关注,ChatGPT 在五天内吸引了 100 万用户,但完整的技术栈才能支撑长期竞争。芯片、研究、产品三个层次的能力缺一不可,每一层的长期投入都会在关键时刻发挥作用。

这对其他玩家意味着什么?OpenAI 仍然在用户规模上领先,但它必须解决算力依赖和资本结构的问题。Meta 正在向 Google 购买芯片,说明它也在学习「全栈」路径。中国的字节、阿里、腾讯都在尝试类似的布局,但芯片层面的供应链限制让这条路更加艰难。

更深层的问题是:当 AI 竞赛从「谁的模型更好」转向「谁控制完整技术栈」时,创业公司的空间在哪里?如果未来的 AI 竞争需要十年芯片研发、数十亿美元人才投资、以及数亿用户的产品生态,那么这个游戏还有多少玩家能参与?

Google 用三年时间证明了一件事:在 AI 时代,技术深度比产品速度更具决定性。2022 年 11 月,ChatGPT 定义了 AI chatbot 的产品形态。2025 年 11 月,Gemini 3 重新定义了竞争规则。掌控从芯片到产品的完整技术栈,才是真正的护城河。